小红书网站架构分析

好的芬克斯的提问,这是一个非常棒的问题!小红书的网站架构是其成功的关键之一,它是一个典型的社区 + 电商”的复杂混合体,我们可以从多个维度来深入分析它的架构。

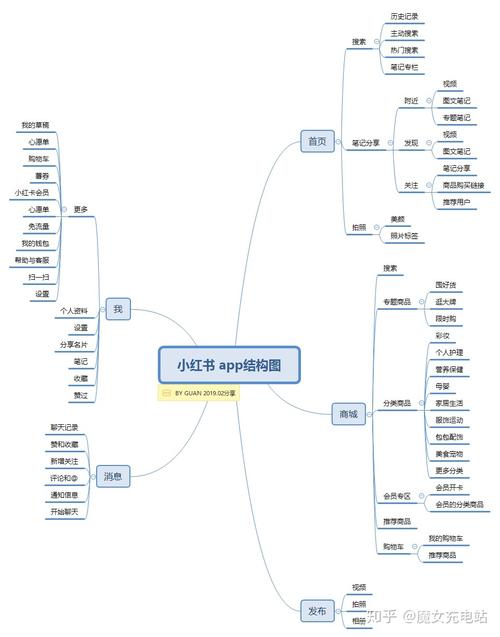

(图片来源网络,侵删)

核心业务与架构特点

在深入技术细节前,我们先理解小红书的业务本质,这决定了其架构的特点:

- UGC (用户生成内容) 驱动:核心是用户分享的“种草笔记”,这要求架构能高效处理海量的文本、图片、视频内容的上传、存储、检索和分发。

- 强社交属性:关注、点赞、收藏、评论、私信等功能,要求系统具备高并发的实时交互能力。

- “种草-拔草”闭环发现(浏览笔记)到交易(购买商品)的无缝衔接,要求内容系统与电商系统深度耦合,但又需要解耦以保证各自独立性和扩展性。

- 高并发与高可用:作为国民级App,尤其是在节假日或热点事件期间,流量会呈现脉冲式增长,对系统的弹性和稳定性要求极高。

- 推荐算法是核心引擎:“猜你喜欢”是用户留存和活跃的关键,其背后是复杂的、需要低延迟响应的推荐系统。

基于以上特点,小红书的架构必然是分布式、微服务化、云原生的。

整体架构概览(分层模型)

我们可以将小红书的整体架构划分为以下几个核心层次:

用户接入层

- 职责:流量的入口,负责请求的接入、路由、安全防护和限流。

- 技术选型:

- DNS服务:使用自研或第三方DNS服务进行智能解析,将用户路由到最近的接入点。

- CDN (Content Delivery Network):至关重要,用于缓存静态资源(图片、CSS、JS、视频)和部分热门动态内容,极大地减轻了源站压力,加速了用户访问。

- API网关:所有客户端请求(App、Web、小程序)的统一入口,负责请求路由、身份认证、权限校验、流量控制、日志记录和监控,可能使用自研网关或基于Nginx、Kong、Spring Cloud Gateway等框架构建。

- 负载均衡:在网关和后端服务之间,使用SLB (Server Load Balancer) 或 F5 硬件设备进行流量分发,确保服务集群的流量均匀。

应用服务层

- 职责:处理核心业务逻辑,是架构的“肌肉”。

- 架构风格:微服务架构,将庞大的单体应用拆分为多个独立、松耦合的服务。

- 核心微服务举例:

- 用户服务:负责用户注册、登录、个人信息管理、关系链(关注/粉丝)。

- 内容服务:笔记的发布、编辑、删除、查询,是整个系统的核心。

- 关系服务:处理点赞、收藏、评论、私信等社交关系。

- 电商服务:商品管理、订单处理、购物车、交易流程。

- 搜索服务:提供全文检索能力,支持笔记、用户、商品的搜索。

- 通知服务:处理点赞、评论、关注、系统消息等推送。

- 风控服务:识别和处理垃圾信息、刷量、作弊等行为。

- 推荐服务:大脑中的大脑,负责生成“猜你喜欢”、“关注推荐”等个性化流。

数据存储层

- 职责:持久化存储业务数据,是架构的“记忆”。

- 技术选型:根据数据类型和业务场景,采用多种数据库混合存储。

- 关系型数据库:

- MySQL / PostgreSQL:用于存储强一致性要求高的数据,如用户信息、订单、商品结构化信息,通常采用主从复制和分库分表来应对高并发和数据量增长。

- NoSQL数据库:

- Redis:缓存之王,用于缓存热点数据(如首页流、热门笔记)、存储Session、实现计数器(点赞数)、做分布式锁等,对性能要求极高。

- MongoDB:可能用于存储一些非结构化的笔记内容或日志数据。

- Elasticsearch:搜索引擎,为搜索服务提供强大的全文检索、聚合分析能力。

- 对象存储:

- 自研或基于AWS S3/阿里云OSS:海量图片和视频的存储,用户上传的笔记内容最终都存储在这里,通过CDN进行分发。

- 图数据库:

- Neo4j / 自研图计算引擎:用于深度挖掘社交关系,进行“你可能认识的人”等高级推荐。

- 关系型数据库:

中间件/支撑层

- 职责:连接各个组件,提供消息传递、任务调度等基础能力。

- 技术选型:

- 消息队列:

- Kafka / RabbitMQ / Pulsar:系统解耦的利器,用于服务间的异步通信,用户发布笔记后,内容服务只需将消息发送到MQ,然后由搜索服务、推荐服务、通知服务等异步地去消费和处理,而不是同步调用,大大提高了系统的响应能力和可用性。

- 分布式任务调度:

- XXL-Job / Elastic-Job / 自研调度系统:用于执行定时任务,如数据统计、报表生成、垃圾信息清理、推荐模型的重训练等。

- 配置中心:

- Apollo / Nacos:集中管理所有微服务的配置,实现配置的动态更新,无需重启服务。

- 消息队列:

核心引擎层:推荐与搜索系统

这是小红书技术壁垒最高的部分,通常独立于常规的微服务架构。

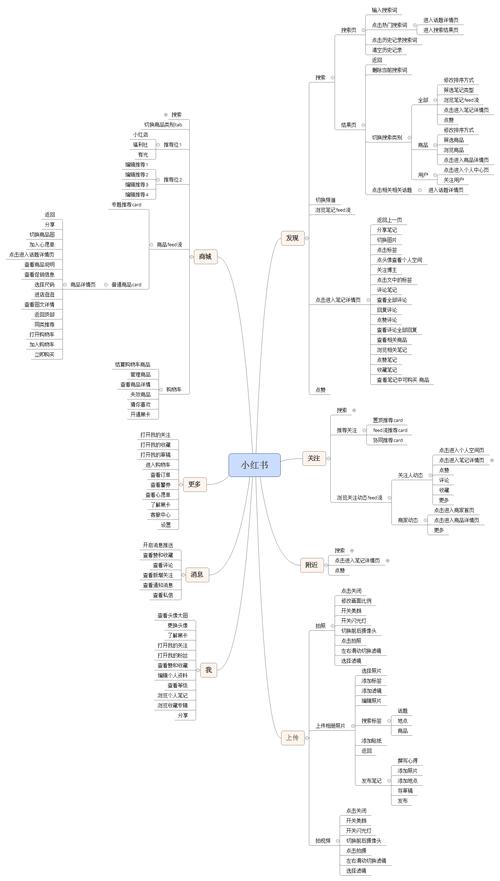

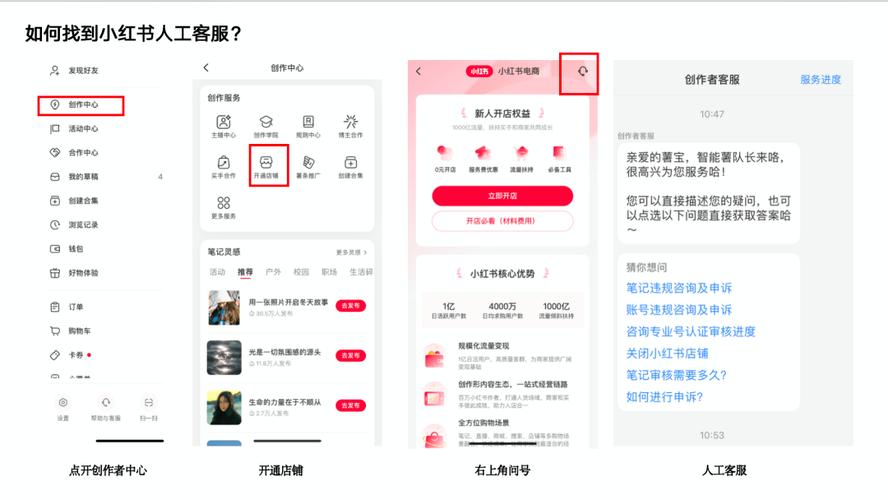

(图片来源网络,侵删)

- 推荐系统:

- 架构:一个典型的“召回 + 排序 + 重排”的多阶段流水线。

- 召回:从海量内容中快速筛选出几百个候选集,策略包括协同过滤、基于内容(标签、主题)的召回、图召回(基于社交关系)等。

- 排序:对召回的候选集进行精准排序,预测用户对每个内容的点击/互动概率,使用复杂的机器学习模型(如深度学习模型),需要强大的特征工程和实时/离线训练平台支持。

- 重排:在排序结果的基础上,进行多样性、公平性、新颖性等规则的调整。

- 搜索系统:

- 基于 Elasticsearch 构建,但会进行深度定制和优化。

- 包含查询理解(识别用户意图)、相关性排序(BM25 + 机器学习模型)、结果去重、冷启动处理等模块。

架构演进与关键技术挑战

架构演进路径

- 早期阶段:可能是单体架构,快速开发,上线验证。

- 成长阶段:随着业务复杂度和用户量增长,单体应用变得臃肿,开发效率低,于是开始向垂直拆分的微服务架构演进。

- 成熟阶段:面对“双十一”级别的流量洪峰,需要对系统进行云原生改造,全面容器化(Docker),采用Kubernetes (K8s)进行容器编排,实现弹性伸缩、服务发现和故障自愈,全面拥抱Service Mesh (服务网格)来处理服务间的通信,进一步解耦和增强可观测性。

关键技术挑战与解决方案

- 海量图片/视频的存储与处理

- 解决方案:对象存储 + CDN 是业界标准,自研或使用成熟的云服务,结合智能调度和压缩技术来优化成本和性能。

- 高并发下的读写性能

- 解决方案:缓存先行,对热点数据使用 Redis 多级缓存,数据库层面采用读写分离、分库分表,对于写多读少的场景,通过MQ进行异步削峰填谷。

- 推荐系统的低延迟与高精度

- 解决方案:

- 架构:采用在线/离线分离的架构,离线集群负责模型训练和特征计算,在线集群负责实时特征更新和在线推理。

- 技术:使用 Flink/Spark 进行实时流处理和离线批处理,使用 TensorFlow/PyTorch 训练深度学习模型,模型服务化部署,使用 TensorFlow Serving/Seldon Core 提供低延迟的推理接口。

- 解决方案:

- 数据一致性(分布式事务)

- 场景:用户下单,需要同时扣减库存、创建订单、增加用户积分。

- 解决方案:根据业务场景选择不同方案,对于强一致性要求高的场景,采用 TCC (Try-Confirm-Cancel) 或 Saga 模式,对于最终一致性要求高的场景,依赖 MQ 的可靠投递和事务消息机制。

- 系统稳定性与容灾

- 解决方案:

- 多可用区部署:核心服务在多个物理机房部署,避免单点故障。

- 限流与降级:在网关和服务层面设置限流规则,保护核心服务,当系统压力过大时,自动降级非核心功能(如关闭部分推荐策略、简化页面)。

- 完善的监控与告警:使用 Prometheus + Grafana 进行 metrics 监控,ELK Stack (Elasticsearch, Logstash, Kibana) 进行日志聚合,建立全链路追踪系统(如 Jaeger/Zipkin),快速定位问题。

- 解决方案:

小红书的网站架构是一个为社区”和“高并发场景”而生的、高度成熟和复杂的分布式系统,其核心特点可以概括为:

- 以微服务为基础:实现了业务模块的解耦和独立演进。

- 以数据为中心:根据业务特性,灵活组合关系型、NoSQL、搜索引擎等多种数据库。

- 以缓存为加速器:Redis和CDN是其性能保障的关键。

- 以消息队列为解耦利器:保证了系统的异步处理能力和高可用性。

- 以推荐算法为灵魂:通过离线与在线结合的机器学习平台,驱动用户增长和商业价值。

- 以云原生为方向:通过K8s和Service Mesh,构建了具备极致弹性和可观测性的现代化技术底座。

这个架构体系支撑了小红书从一个小众社区成长为今天的“生活方式第一平台”的全过程,并且仍在不断演进,以应对未来更大的挑战和机遇。

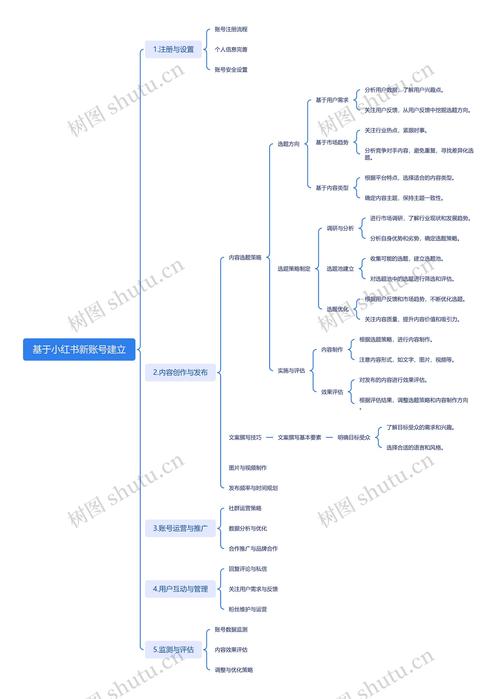

(图片来源网络,侵删)

文章版权及转载声明

作者:99ANYc3cd6本文地址:https://www.chumoping.net/post/21686.html发布于 今天

文章转载或复制请以超链接形式并注明出处初梦运营网